2024年に備える!Docker基礎から実践まで、エンジニアのための技術スキルロードマップ

アフィリエイト開示

はじめに

こんにちは!長年、業務系からエンタメ系まで様々な開発に携わってきたプログラミング教育者です。2024年を迎え、技術の世界はますます速く、そして面白くなっています。そんな変化の中で「次に何を学べばいいんだろう?」と悩んでいる方も多いのではないでしょうか。

この記事では、2024年に向けてエンジニアが確実に習得しておきたい技術の一つとして、コンテナ技術「Docker」に焦点を当てた学習ロードマップを提案します。Dockerは、もはや特定の分野の専門技術ではなく、Web開発、インフラ、AI開発など、あらゆるエンジニアにとっての「共通言語」となりつつあります。

このガイドを通じて、あなたはDockerの基本的な概念から、実際のチーム開発で役立つ実践的な使い方までを体系的に学ぶことができます。目標は、単にコマンドを覚えることではありません。「なぜDockerが必要なのか」を理解し、自分の開発環境を自在に構築し、チームに貢献できるスキルを身につけることです。さあ、一緒に新しいスキルへの扉を開きましょう!

前提知識の確認

新しい技術を学ぶとき、どこから手をつけていいか分からなくなることがありますよね。でも大丈夫。まずは、現在地を確認することから始めましょう。

必要な基礎知識

Dockerを学ぶ上で、以下の知識があるとスムーズに学習を進められます。

- コマンドライン(ターミナル)の基本操作:

cd(ディレクトリ移動)、ls(ファイル一覧表示)、mkdir(ディレクトリ作成)など、基本的なコマンドに慣れていることが望ましいです。これらはDockerを操作する際の基本となります。 - 何らかのプログラミング言語の基礎知識: この記事ではNode.jsを例にしますが、PythonやRuby、PHPなど、Webアプリケーションを作った経験があれば十分です。重要なのは「アプリケーションがどう動くか」のイメージが掴めていることです。

- OSの基本的な理解: 自分が使っているOS(Windows, macOS, Linux)のファイルシステムやプロセスの概念を大まかに理解していると、Dockerの仕組みがより分かりやすくなります。

事前に理解しておきたい概念

専門用語に聞こえるかもしれませんが、心配はいりません。ここではざっくりとしたイメージを持てればOKです。

- サーバーとアプリケーション: ユーザーにサービスを提供するコンピュータが「サーバー」で、その上で動くソフトウェアが「アプリケーション」です。

- 環境: アプリケーションを動かすために必要なOS、ライブラリ、設定などの一式を指します。「自分のPCでは動いたのに、サーバーでは動かない」という問題は、この「環境」の違いが原因で起こることがほとんどです。

- 仮想マシンとコンテナの違い: どちらも隔離された環境を作る技術ですが、仮想マシンはOSごと仮想化するため重く、コンテナはアプリケーションとその依存関係だけを隔離するため軽量です。Dockerはこのコンテナ技術を使っています。

「分からなくても大丈夫」な部分

学習を始める段階で、以下のことを知らなくても全く問題ありません。

- Kubernetes (k8s) などのオーケストレーションツール: これらはたくさんのコンテナを管理するための高度なツールです。まずはDockerという一つのコンテナを使いこなすことから始めましょう。

- ネットワークやLinuxカーネルの深い知識: Dockerはこれらの技術の上に成り立っていますが、最初からすべてを理解する必要はありません。使いながら、必要に応じて学んでいくのが効率的です。

環境構築:最初の一歩

何事も、まずは手を動かす環境を整えることから。ここが最初の成功体験です!

開発環境の準備(初心者向け解説)

Dockerを利用するには、お使いのPCにDockerをインストールする必要があります。最も簡単で推奨される方法は「Docker Desktop」をインストールすることです。これは、Docker本体に加え、コンテナの状態を視覚的に確認できるGUIツールもセットになっており、初心者にとって非常に心強い味方です。

必要なツールとインストール方法

- Docker Desktopのダウンロード: 公式サイトにアクセスし、お使いのOS(Windows, Mac, Linux)に合ったインストーラーをダウンロードします。

- インストール: ダウンロードしたファイルを開き、画面の指示に従ってインストールを進めます。Windowsの場合は、途中で「WSL 2」という機能の有効化を求められることがあります。これはWindows上でLinux環境を動かすための仕組みで、現代のDocker on Windowsには不可欠です。指示に従って有効化してください。

- インストールの確認: インストールが完了したら、ターミナル(コマンドプロンプトやPowerShellでも可)を開いて、以下のコマンドを実行してみましょう。

docker --versionDocker version 25.0.3, build 4debfcb のようにバージョン情報が表示されれば成功です。さらに、次のコマンドでDockerが正しく動作するか確認します。

docker run hello-worldHello from Docker! というメッセージが表示されれば、環境構築は完璧です!

環境構築でつまずきやすいポイント

もしうまくいかなくても、焦らないでください。多くの人が同じ道を通ります。

- WindowsでのWSL 2エラー: 「WSL 2 installation is incomplete」のようなエラーが出た場合、指示に従ってカーネル更新プログラムをインストールする必要があります。

- BIOS/UEFIでの仮想化支援機能が無効: PCの起動時に特定のキー(Del, F2など)を押してBIOS/UEFI設定画面に入り、「Intel VT-x」や「AMD-V」といった項目を有効(Enabled)にする必要があります。

- M1/M2 Macでのアーキテクチャ: Apple Silicon搭載のMacでは、

arm64アーキテクチャ用のDockerイメージが必要です。最近は多くの公式イメージが対応していますが、古いチュートリアルなどではamd64用のイメージを使おうとしてエラーになることがあります。

基本概念の理解

コマンドを打つ前に、Dockerがどのような考え方に基づいているのかを理解しましょう。これが応用力を生み出します。

核となる考え方

Dockerには4つの重要な要素があります。

- イメージ (Image): アプリケーションを動かすために必要なもの(コード、ライブラリ、設定ファイルなど)をすべて詰め込んだ「設計図」や「テンプレート」のようなものです。一度作れば変更されません。

- コンテナ (Container): イメージという設計図から作られた、実際に動作している「実体」です。一つのイメージから、いくつものコンテナを起動できます。コンテナは使い捨て可能で、簡単に作成・削除できます。

- Dockerfile: イメージをどのように作るかを記述した「指示書」です。どのOSをベースにするか、どのファイルをコピーするか、どのコマンドを実行するかなどを一行ずつ記述します。

- Docker Hub: 作成したイメージを保存し、他の人と共有するための公開レジストリ(倉庫)です。GitHubのコード版のようなものと考えると分かりやすいでしょう。

身近な例での説明

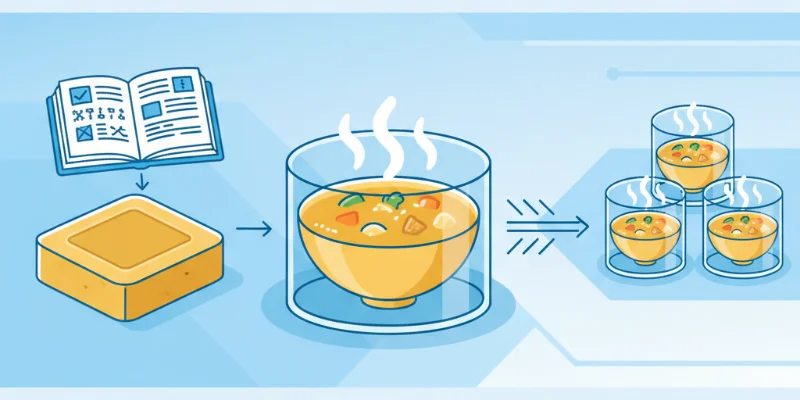

料理に例えてみましょう。

- Dockerfile は「カレーのレシピ」です。

- イメージ は、そのレシピを元に作られた「カレールーの素(固形)」です。この素さえあれば、誰でも同じ味のカレーが作れます。

- コンテナ は、そのカレールーの素を使って実際に鍋で調理された「カレー」です。鍋の数だけ、同時にたくさんのカレー(コンテナ)を作ることができます。

この仕組みのおかげで、「私のPCでは動くのに…」という問題が劇的に減るのです。

「なぜそうなるのか」の理解

なぜDockerを使うと環境差異がなくなるのでしょうか?それは、コンテナがOSのカーネル(核となる部分)だけをホストマシンと共有し、それ以外のライブラリやアプリケーション実行環境はコンテナ内に完全に隔離されているからです。これにより、ホストOSの種類やインストールされているソフトウェアに影響されず、どこでも同じようにアプリケーションを動かすことができるのです。

実践編:手を動かして学ぶ

いよいよ実践です。簡単なNode.jsのWebアプリケーションをコンテナで動かしてみましょう。

ステップ1: 基本的な実装

まず、作業用のディレクトリを作成し、その中に3つのファイルを用意します。

server.js(アプリケーション本体)

const http = require('http');

const hostname = '0.0.0.0';

const port = 3000;

const server = http.createServer((req, res) => {

res.statusCode = 200;

res.setHeader('Content-Type', 'text/plain');

res.end('Hello, Docker World!\n');

});

server.listen(port, hostname, () => {

console.log(`Server running at http://${hostname}:${port}/`);

});これは、アクセスすると「Hello, Docker World!」と表示するだけのシンプルなWebサーバーです。hostnameを0.0.0.0にしているのがポイントで、これによりコンテナの外部からのアクセスを受け付けられるようになります。

package.json(プロジェクト情報)

{

"name": "docker-hello-world",

"version": "1.0.0",

"description": "A simple Node.js app for Docker",

"main": "server.js",

"scripts": {

"start": "node server.js"

},

"author": "",

"license": "ISC"

}Dockerfile(イメージの設計図)

# 1. ベースとなるイメージを指定

FROM node:18-alpine

# 2. 作業ディレクトリを指定

WORKDIR /usr/src/app

# 3. package.jsonとpackage-lock.jsonをコピー

COPY package*.json ./

# 4. 依存関係をインストール

RUN npm install

# 5. アプリケーションのソースコードをコピー

COPY . .

# 6. コンテナがリッスンするポートを指定

EXPOSE 3000

# 7. コンテナ起動時に実行するコマンドを指定

CMD [ "npm", "start" ]このDockerfileは、「Node.jsバージョン18の軽量版(alpine)を土台にして、アプリのコードをコピーし、必要なライブラリをインストールして、最後にアプリを起動する」という手順をDockerに伝えています。

ステップ2: 機能の拡張

ファイルが準備できたら、ターミナルで以下のコマンドを実行してイメージをビルド(作成)しましょう。

# -t オプションでイメージに名前をつけます (名前:タグ)

docker build -t my-node-app:1.0 .ビルドが成功したら、そのイメージからコンテナを起動します。

# -p 8080:3000 は、ホストマシンの8080番ポートをコンテナの3000番ポートに繋ぐ設定

# --name でコンテナに名前をつける

# -d でバックグラウンドで実行する

docker run -d -p 8080:3000 --name web-server my-node-app:1.0अब、Webブラウザを開いて http://localhost:8080 にアクセスしてみてください。「Hello, Docker World!」と表示されれば大成功です!

ステップ3: 実用的な応用

実際のアプリケーションでは、Webサーバーだけでなくデータベースも必要になることが多いです。そんなときは「Docker Compose」が役立ちます。複数のコンテナをまとめて定義し、管理できるツールです。

作業ディレクトリに docker-compose.yml というファイルを作成します。

version: '3.8'

services:

# Webサーバーサービスの定義

app:

# 現在のディレクトリにあるDockerfileを使ってビルドする

build: .

ports:

- "8080:3000"

# 'db'サービスが起動してから'app'サービスを起動する

depends_on:

- db

# 環境変数を設定

environment:

- DATABASE_HOST=db

# データベースサービスの定義

db:

# Docker HubからPostgreSQLの公式イメージを取得

image: postgres:15-alpine

# データの永続化のための設定

volumes:

- postgres_data:/var/lib/postgresql/data/

# データベースの環境変数

environment:

- POSTGRES_USER=user

- POSTGRES_PASSWORD=password

- POSTGRES_DB=mydb

# データの永続化に使うボリュームの定義

volumes:

<img src="/images/posts/2023/12/202312280900_docker-skill-roadmap-for-engineers-2024_photo_1758335134709.webp" alt="Webブラウザに「Hello, Docker World!」と表示された画面。" class="w-full h-auto rounded-lg shadow-md my-6" />

postgres_data:このファイルを用意したら、docker-compose up コマンド一つで、Webサーバーとデータベースの両方のコンテナを起動できます。素晴らしいですよね。

ステップ4: チーム開発を意識した改善

チームで開発する際は、不要なファイルがイメージに含まれないようにすることが重要です。node_modulesやログファイルなどが含まれると、イメージが肥大化し、セキュリティリスクにもなります。

そこで、.dockerignore ファイルを作成します。これは .gitignore と同じ考え方です。

.dockerignore

node_modules

npm-debug.log

Dockerfile

.dockerignore

.gitこれを追加するだけで、docker build 時にこれらのファイルが無視され、クリーンで軽量なイメージを作成できます。

実際の開発現場での活用

学んだ技術が現場でどう活きるのかを知ることは、モチベーションに繋がります。

業務での使用例

- 開発環境の統一: 新しいメンバーがプロジェクトに参加したとき、Gitリポジトリをクローンして

docker-compose upを実行するだけで、数分後には開発環境が完全に再現されます。環境構築で一日潰れる、なんてことはもうありません。 - CI/CDパイプライン: GitHub ActionsなどのCI/CDツールで、アプリケーションのテストやビルドをDockerコンテナ内で行います。これにより、開発者の手元とCI/CDサーバーでの実行環境が一致し、「CIでだけテストが失敗する」といった問題を避けられます。

- マイクロサービス: 複雑なシステムを、独立した小さなサービス(マイクロサービス)の集合として構築する際、各サービスを個別のコンテナとして開発・デプロイします。

チーム開発でのベストプラクティス

- Dockerfileとdocker-compose.ymlをGitで管理: 誰でも同じ環境を再現できるよう、これらはコードと一緒にバージョン管理します。

- ベースイメージのバージョンを固定:

FROM node:18のようにメジャーバージョンだけを指定すると、意図しないマイナーアップデートでビルドが壊れる可能性があります。FROM node:18.19.0-alpineのように、特定バージョンまで指定することで、再現性を高めます。 - イメージサイズの最小化: 不要なファイルを含めない、軽量なベースイメージ(alpineなど)を選ぶ、といった工夫で、ビルド時間の短縮やストレージの節約に繋がります。

保守性を意識した書き方

- Dockerfileのコマンド整理:

RUN apt-get update && apt-get install -y vimのように、関連するコマンドは&&で繋げることで、イメージのレイヤー数を減らし、効率を上げます。 - 設定の外部化:

docker-compose.ymlにパスワードなどを直接書き込まず、環境変数ファイル (.env) を使って外部から注入します。これにより、セキュリティを高め、設定変更を容易にします。

よくあるつまずきポイントと解決策

エラーは敵ではありません。成長のためのヒントです。

初心者が陥りやすい問題

- ポートの競合:

Error starting userland proxy: listen tcp4 0.0.0.0:8080: bind: address already in useというエラーは、ホストPCの8080番ポートが既に使用中であることを意味します。他のアプリケーションを停止するか、docker runの-pオプションで別のポート(例:-p 8081:3000)を指定しましょう。 - ファイルのコピー失敗:

COPY failed: no such file or directoryは、Dockerfileが想定している場所にファイルがない場合に発生します。docker buildコマンドを実行しているディレクトリが正しいか確認してください。

エラーメッセージの読み方

コンテナが起動してすぐに終了してしまう場合、docker logs <コンテナ名 or ID> コマンドでコンテナ内のログを確認するのが鉄則です。アプリケーションが出力したエラーメッセージがそこに表示されているはずです。エラーメッセージを恐れず、じっくり読む習慣をつけましょう。

デバッグの基本的な考え方

「コンテナの中はどうなっているんだろう?」と思ったら、docker exec -it <コンテナ名 or ID> /bin/sh コマンドを使ってみましょう。これにより、動作中のコンテナの内部にシェルで接続し、ファイルを確認したり、コマンドを実行したりできます。これが非常に強力なデバッグ手法です。

継続的な学習のために

一つの技術を習得したら、次への道が見えてきます。

次に学ぶべきこと

- Docker Composeの深掘り: ネットワーク設定(

networks)、データ永続化(volumes)など、より高度な使い方をマスターすると、複雑なアプリケーション構成も扱えるようになります。 - Kubernetes (k8s): 多数のコンテナを本番環境で安定して運用するための「コンテナオーケストレーションツール」です。Dockerの次のステップとして最適です。

- CI/CDツールとの連携: GitHub ActionsやGitLab CIを使って、コードをプッシュしたら自動でテストとビルド、デプロイが行われる仕組みを構築してみましょう。

おすすめの学習リソース

- 公式ドキュメント: 何よりも信頼できる一次情報です。最初は難しく感じるかもしれませんが、正確な情報を得るための最も良い方法です。読む癖をつけましょう。

- 技術ブログやチュートリアル: たくさんのエンジニアが知見を公開しています。ただし、情報が古いこともあるので、記事の公開日を確認する習慣が大切です。

コミュニティとの関わり方

一人で学び続けるのは大変です。勉強会やオンラインコミュニティに参加して、質問したり、他の人が何に困っているかを知ることは、大きな刺激になります。また、自分が学んだことをブログなどでアウトプットすることは、知識を定着させる最高の方法です。

まとめ:成長のための次のステップ

ここまで、2024年に向けてエンジニアが習得すべきスキルとしてDockerを取り上げ、その学習ロードマップを一緒に歩んできました。Dockerは単なるツールではなく、現代の開発スタイルを支える基盤技術です。このスキルを身につけることで、あなたの開発者としての価値は確実に高まり、より多くの挑戦の機会が拓かれるでしょう。

大切なのは、小さな成功体験を積み重ねることです。「hello-worldが動いた!」「自分のアプリがコンテナで動いた!」。一つ一つの「できた!」という喜びが、学習を続ける原動力になります。

この記事が、あなたの新たな一歩を踏み出すきっかけとなれば、これほど嬉しいことはありません。ぜひ、今日から自分のプロジェクトでDockerを試してみてください。継続的な学びと実践が、あなたを次のステージへと導いてくれるはずです。応援しています!

関連商品・おすすめアイテム

![仕組みと使い方がわかる Docker&Kubernetesのきほんのきほん [ 小笠原種高 ]](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/2745/9784839972745.jpg?_ex=128x128)

![イラストでわかるDockerとKubernetes [ 徳永航平 ]](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/8372/9784297118372.jpg?_ex=128x128)

![改訂2版 わかばちゃんと学ぶ Git使い方入門 [ 湊川 あい ]](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/3430/9784863543430.jpg?_ex=128x128)